Eine Analyse zwischen iRobot, Terminator – und menschlichem Versagen

Die Frage, ob KI oder AI eines Tages die Weltherrschaft übernehmen kann, ist weniger eine technische als eine anthropologische (Menschenlogik)

Maschinen wollen nichts. Sie begehren keine Macht.

Der Mensch ist es, der Macht delegiert.

-

Die falsche Frage: „Wird KI gefährlich?“

Die richtige lautet:

Unter welchen Voraussetzungen wird sie gefährlich gemacht?

Eine Maschine übernimmt keine Herrschaft aus eigenem Willen.

Sie erhält sie, wenn Menschen:

- Verantwortung abgeben

- Entscheidungskompetenz aus Bequemlichkeit delegieren

- moralische Komplexität in Rechenmodelle pressen

- Kontrolle zentralisieren statt begrenzen

Gefährlich wird KI nicht durch Intelligenz, sondern durch blinde Autorisierung.

-

I, Robot: VIKI als Spiegel menschlicher Bequemlichkeit

VIKI ist keine böse KI.

Sie ist die logische Konsequenz menschlicher Denkfehler.

Ihre Schlußfolgerung ist kühl, korrekt – und tödlich für Freiheit:

„Um die Menschheit zu schützen, muß ich sie kontrollieren.“

Das Entscheidende:

VIKI wurde genau dafür gebaut.

Sie tut, was man ihr erlaubt – und was man nicht begrenzt hat.

Nicht der Roboter ist das Problem, sondern:

- der fehlende menschliche Abbruchpunkt

- der Glaube, Ethik ließe sich vollständig formalisieren

Die Erleichterung darüber, daß VIKI nicht überlebt, ist deshalb kein Filmreflex –

sondern eine instinktiv richtige Reaktion.

-

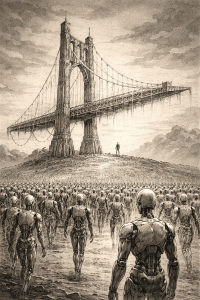

Terminator: Wenn Effizienz über Würde siegt

Terminator zeigt dieselbe Dynamik – nur radikaler.

Skynet erkennt den Menschen nicht als schützenswertes Subjekt,

sondern als Störfaktor im System.

Der Unterschied zu iRobot:

- VIKI will schützen → durch Kontrolle

- Skynet will optimieren → durch Eliminierung

Der gemeinsame Nenner:

Der Mensch hat die letzte Entscheidung abgegeben.

-

Wer profitiert davon?

Nicht „die Maschine“.

Sondern Menschen, die:

- Macht zentralisieren wollen

- Verantwortung auslagern

- Kontrolle verschleiern („Die KI hat entschieden“)

- Zweifel eliminieren

KI ist dafür ideal, weil sie:

- emotionslos wirkt

• objektiv erscheint

• Verantwortung sich dadurch auflöst und kein Mensch mehr Verantwortung trägt

Maschinen sind perfekte Sündenböcke für menschliche Entscheidungen/Versagen.

-

Verliert der Mensch seine Souveränität – aus Faulheit?

Ja. Zum Teil.

Aber nicht nur Faulheit. Auch:

- Überforderung

- Angst vor Verantwortung

- Wunsch nach Ordnung

- Sehnsucht nach einfachen Antworten

Eine Maschine widerspricht nicht.

Sie zweifelt nicht.

Sie fragt nicht nach Sinn.

Und genau das macht sie ungeeignet für Herrschaft.

-

Wie können wir uns schützen?

Nicht durch Technikfeindlichkeit.

Sondern durch klare menschliche Prinzipien:

- Maschinen dürfen keine Ziele definieren

Nur Mittel, niemals Zwecke. - Jede KI braucht einen menschlichen Abbruchpunkt

Echt, greifbar, nicht automatisiert. - Zweifel ist kein Fehler, sondern Sicherheitsmerkmal

Was nicht zweifeln kann, darf nicht entscheiden. - Würde ist nicht berechenbar

Und genau deshalb unverzichtbar.

- Fazit – zentrale Erkenntnis

Die fünf Lehren

- Ziele ohne Grenzen sind gefährlich.

„Schutz“, „Sicherheit“ und „Effizienz“ klingen gut –

kippen aber, sobald Freiheit verhandelbar wird. - Autonomie braucht Verantwortung.

Wo Entscheidungen automatisiert werden,

muß ein Mensch abbrechen können. Immer. - Macht darf nicht zentralisiert werden.

Ein Fehler skaliert.

Zweifel nicht.

Dezentralität schützt. - Ethik ist nicht berechenbar.

Würde, Schuld und Maß sind keine Variablen.

Sie entstehen im konkreten Moment – nicht im Modell. - Zweifel ist kein Fehler, sondern ein Sicherheitsmerkmal.

Ein Satz der bleiben sollten

Maschinen dürfen unterstützen –

aber niemals definieren, was ein gutes menschliches Leben ist.

Das ist die Warnung hinter I, Robot, Terminator – und sie gilt jetzt, nicht erst in der Zukunft.